《麻省理工科技评论》报道,苹果公司的研究人员正在探索一种前沿技术,旨在通过人工智能识别用户与 iPhone 等设备的交谈,从而消除像“Siri”这样的触发短语的技术需求。

在这项上传到 Arxiv 且未经同行评审的研究中。研究人员利用智能手机捕捉的语音数据和背景噪音的声学信息,训练了一个大型语言模型。该模型的目标是识别那些可能表明用户需要设备辅助的情境或模式。

论文指出,这个模型的部分构建是基于 OpenAI 的 GPT-2,这种轻量级的结构使得它能够在智能手机等设备上高效运行。论文还描述了用于训练模型的超过 129 小时的数据、额外的文本数据,但没有说明训练集的录音来源。据领英个人资料,七位作者中有六位列出他们的隶属关系为苹果公司,其中三人在苹果 Siri 团队工作。

论文的结论颇具启发性,它指出,与单纯的音频或文本模型相比,这种混合模型能做出更为准确的预测,并且随着模型规模的扩大,其性能还会得到进一步提升。这意味着,未来的 Siri 可能会更精准地理解用户的意图,无需通过固定的唤醒词来触发。

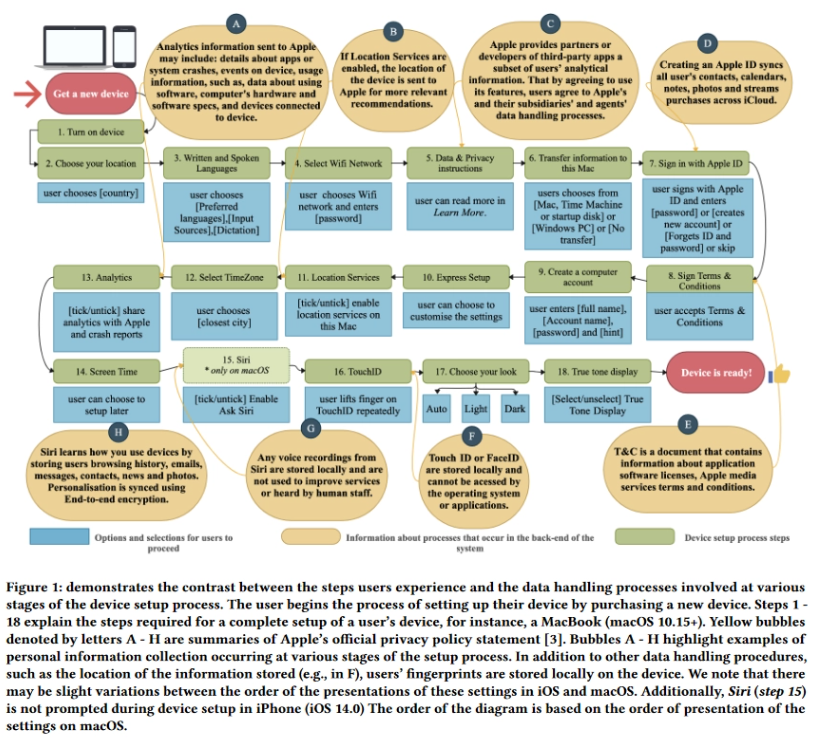

目前,Siri 的功能是通过保留少量音频来实现的,听到“嘿,Siri”等触发短语之前,不会开始录制或准备回答用户提示。

然而,这一创新也引发了一些关于隐私和数据安全的担忧。斯坦福人类中心人工智能研究所的隐私和数据政策研究员詹・金指出,取消“嘿,Siri”这样的触发短语可能会让人们更加担心设备是否在“始终监听”。